Internet Archive следит за правильностью ссылок в Википедии

Опубликовал: FIELD LINE, 8-10-2018, 05:08, В мире / Железо, 3 273, 0

Одной из главных проблем Википедии являются отнюдь не тролли, которые дописывают ерунду в статьи. Правки можно откатить. А вот ситуация с данными третьей стороны куда серьёзнее. Каждую неделю в Википедию и Викимедию добавляют порядка 20 миллионов ссылок. Но если исходный материал удалён — достоверность информации в статье доказать сложнее. Проект Internet Archive по мере сил пытается решить эту проблему. Последние 5 лет участники «Интернет-архива» поддерживают версии Википедии на 22 языках, актуализируя почти 9 миллионов ссылок. А с 2015 года программный бот под названием IABot автоматизировал процесс.

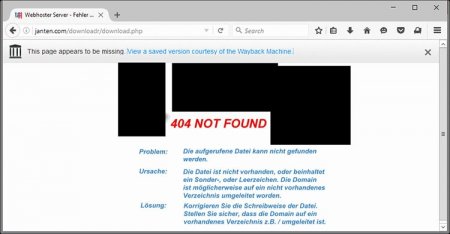

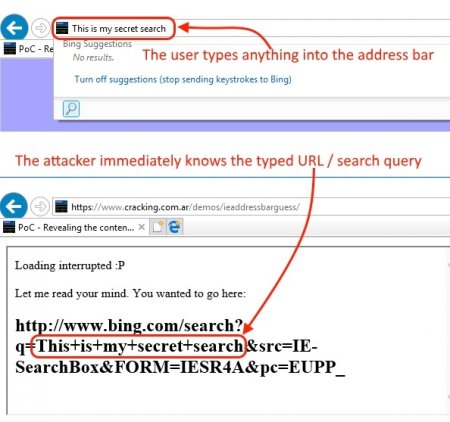

Если бот находит «повреждённую» ссылку, то ищет соответствие ей в Wayback Machine и других веб-архивах для их замены. В будущем планируется расширить функциональность IABot для мониторинга других сайтов, научных статей и прочего.

К слову, такая проблема касается не только Википедии. Подобное обнаруживалось на сайте Верховного суда США, где почти половина ссылок была нерабочей. Подобное наблюдается также на ресурсах, которые долгое время не поддерживаются или были взломаны.

В целом, это вполне своевременный проект. Ранее Facebook уже запустил систему на основе искусственного интеллекта для поиска фейковых новостей. Похожее есть у Google и других интернет-гигантов. Подобный подход вполне логичен в свете лавинообразного роста количества информации.

При этом интернет-архивы тоже не могу считаться панацеей. При архивации возможны различные сбои и проблемы, особенно если на сайте много jаvascript-кода. В этом случае Wayback Machine может не полностью скопировать содержимое. Более того, многие данные удаляют на самих платформах — этим «славится» YouTube, который в последнее время всё больше ужесточает требования к перезаливам роликов.

Если бот находит «повреждённую» ссылку, то ищет соответствие ей в Wayback Machine и других веб-архивах для их замены. В будущем планируется расширить функциональность IABot для мониторинга других сайтов, научных статей и прочего.

К слову, такая проблема касается не только Википедии. Подобное обнаруживалось на сайте Верховного суда США, где почти половина ссылок была нерабочей. Подобное наблюдается также на ресурсах, которые долгое время не поддерживаются или были взломаны.

В целом, это вполне своевременный проект. Ранее Facebook уже запустил систему на основе искусственного интеллекта для поиска фейковых новостей. Похожее есть у Google и других интернет-гигантов. Подобный подход вполне логичен в свете лавинообразного роста количества информации.

При этом интернет-архивы тоже не могу считаться панацеей. При архивации возможны различные сбои и проблемы, особенно если на сайте много jаvascript-кода. В этом случае Wayback Machine может не полностью скопировать содержимое. Более того, многие данные удаляют на самих платформах — этим «славится» YouTube, который в последнее время всё больше ужесточает требования к перезаливам роликов.