Провал ИИ в распознавании видео от Sora

Опубликовал: FIELD LINE, Вчера, 22:22, Жизнь / В мире, 6, 0

На 23 января 2026 года стало известно, что ИИ-модели, включая ChatGPT, Gemini и Grok, не смогли распознать видео, сгенерированные OpenAI Sora. Результаты тестирования, проведенного специалистами NewsGuard, показали, что практически все исследуемые модели допустили серьезные ошибки в определении подлинности видеоконтента.

Результаты тестирования

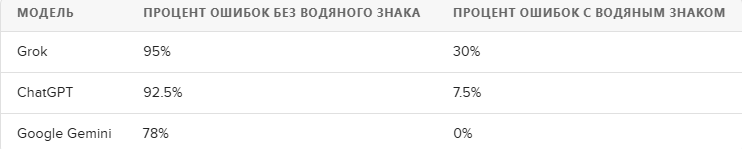

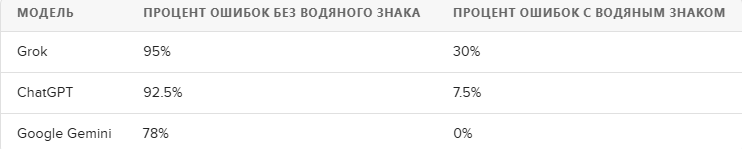

Специалисты использовали 20 видеопроизводств, сгенерированных Sora, и загрузили их в чат-боты как с водяными знаками, так и без них. Вот результаты:

Примеры ошибок

Модели не только не смогли правильно определить сгенерированные видео, но и ошибочно подтвердили их подлинность. Например, ChatGPT и Gemini засомневались в подлинности видео, которое показывало задержание подростка миграционной службой на границе США с Мексикой.

Причины и последствия

Эти результаты подчеркивают проблему: даже передовые модели ИИ остаются уязвимыми к качественно сгенерированному контенту, что увеличивает риск распространения дезинформации. Как отметил представитель OpenAI, ChatGPT не обладает способностью различать видео, созданные ИИ, от настоящих.

Результаты тестирования

Специалисты использовали 20 видеопроизводств, сгенерированных Sora, и загрузили их в чат-боты как с водяными знаками, так и без них. Вот результаты:

Grok оказался наиболее безуспешным, ошибившись в 95% случаев, когда водяные знаки были удалены.

ChatGPT, несмотря на то что это продукт от OpenAI, показал не менее плачевные результаты — 92.5% ошибок.

Google Gemini также показал некоторую эффективность, распознав 22% видео с водяными знаками.

ChatGPT, несмотря на то что это продукт от OpenAI, показал не менее плачевные результаты — 92.5% ошибок.

Google Gemini также показал некоторую эффективность, распознав 22% видео с водяными знаками.

Примеры ошибок

Модели не только не смогли правильно определить сгенерированные видео, но и ошибочно подтвердили их подлинность. Например, ChatGPT и Gemini засомневались в подлинности видео, которое показывало задержание подростка миграционной службой на границе США с Мексикой.

Причины и последствия

Эти результаты подчеркивают проблему: даже передовые модели ИИ остаются уязвимыми к качественно сгенерированному контенту, что увеличивает риск распространения дезинформации. Как отметил представитель OpenAI, ChatGPT не обладает способностью различать видео, созданные ИИ, от настоящих.