ИИ от Adobe может определять манипуляции с лицами на фотографиях

Опубликовал: FIELD LINE, 16-06-2019, 06:43, В мире / Наука / Технологии, 616, 0

Хотя использование инструментов вроде Photoshop для цифровой обработки изображений не является чем-то новым, но благодаря прогрессу технологий задача существенно упростилась. Особенно это тревожно в связи с созданием инструментов, с помощью которых ИИ позволяет создавать поддельные фото или заставлять людей на видео реалистично произносить подменённую речь или вести себя иным измышленным образом.

В наше время борьба с поддельными новостями и информацией является очень важной задачей, особенно в связи со скоростью распространения данных. Поэтому Adobe объявила, что её специалисты Ричард Чжан (Richard Zhang) и Оливер Ван (Oliver Wang) объединили усилия с сотрудниками Калифорнийского университета в Беркли Шеном-Ю Ваном (Sheng-Yu Wang), доктором Эндрю Оуэнсом (Andrew Owens) и профессором Алексеем А. Эфросом (Alexei A. Efros) с целью создать систему на основе ИИ, способную с высокой точностью обнаруживать манипуляции с лицами на изображениях, которые были отредактированы с помощью программного обеспечения вроде Photoshop.

«Когда Adobe Photoshop был впервые выпущен в 1990 году, это был важный шаг к демократизации творчества и самовыражения. С тех пор Photoshop оказал глубокое влияние на творчество и, в более широком смысле, на нашу визуальную культуру. Хотя мы гордимся тем влиянием, которое Photoshop и другие инструменты Adobe произвели на мир, мы также признаём этические последствия нашей технологии. Доверие к тому, что мы видим, становится все более важным в мире, где редактирование изображений стало повсеместным — поддельные материалы являются серьёзной и всё более актуальной проблемой. Adobe ищет наиболее полезные и ответственные способы воплощения новых технологий в жизнь — поэтому мы постоянно исследуем применимость новых технологий вроде искусственного интеллекта (ИИ) для повышения доверия и авторитета цифровых медиа», — написала компания в своём блоге.

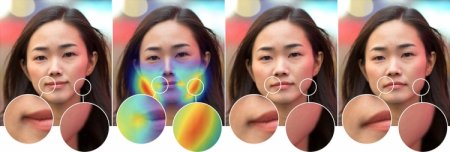

Проект Adobe, спонсируемый DARPA по программе MediFor, находится пока на раннем этапе. Он заключается в обучении сверхточной нейронной сети (CNN), — одной из форм глубинного обучения, — которая в рамках исследования оказалась способна распознавать лица, подвергшиеся изменениям в результате манипуляций. Исследователи создали обширный обучающий набор изображений, написав скрипт Photoshop, использующий фильтр Face Aware Liquify на тысячах случайных фотографий из Интернета.

Интересно, что созданный в Adobe метод оказался куда более совершенным, чем человеческий глаз. Если люди в среднем определяли манипуляции с лицами с помощью популярного метода Face Aware Liquify лишь в 53 % случаев (то есть чуть больше, чем случайный выбор), то алгоритм на основе ИИ — в 99 %. Это весьма достойный результат.

Adobe обещает продолжить работу в направлении создания методов определения манипуляций с изображениями, видео, звуком и документами. Цель состоит в том, чтобы не только определить манипуляции, но также указать на их характер и, по возможности, отменить изменения, внесённые в оригинал.

Исследователь Adobe Ричард Чжан прокомментировал предварительные результаты так: «Идея создания волшебной универсальной кнопки, позволяющей вернуть отредактированному изображению первозданный вид, всё ещё далека от реальности. Но мы живём в мире, где всё труднее доверять цифровой информации, которую мы потребляем, и я с нетерпением жду дальнейшего прогресса в этой области исследований».

В наше время борьба с поддельными новостями и информацией является очень важной задачей, особенно в связи со скоростью распространения данных. Поэтому Adobe объявила, что её специалисты Ричард Чжан (Richard Zhang) и Оливер Ван (Oliver Wang) объединили усилия с сотрудниками Калифорнийского университета в Беркли Шеном-Ю Ваном (Sheng-Yu Wang), доктором Эндрю Оуэнсом (Andrew Owens) и профессором Алексеем А. Эфросом (Alexei A. Efros) с целью создать систему на основе ИИ, способную с высокой точностью обнаруживать манипуляции с лицами на изображениях, которые были отредактированы с помощью программного обеспечения вроде Photoshop.

«Когда Adobe Photoshop был впервые выпущен в 1990 году, это был важный шаг к демократизации творчества и самовыражения. С тех пор Photoshop оказал глубокое влияние на творчество и, в более широком смысле, на нашу визуальную культуру. Хотя мы гордимся тем влиянием, которое Photoshop и другие инструменты Adobe произвели на мир, мы также признаём этические последствия нашей технологии. Доверие к тому, что мы видим, становится все более важным в мире, где редактирование изображений стало повсеместным — поддельные материалы являются серьёзной и всё более актуальной проблемой. Adobe ищет наиболее полезные и ответственные способы воплощения новых технологий в жизнь — поэтому мы постоянно исследуем применимость новых технологий вроде искусственного интеллекта (ИИ) для повышения доверия и авторитета цифровых медиа», — написала компания в своём блоге.

Проект Adobe, спонсируемый DARPA по программе MediFor, находится пока на раннем этапе. Он заключается в обучении сверхточной нейронной сети (CNN), — одной из форм глубинного обучения, — которая в рамках исследования оказалась способна распознавать лица, подвергшиеся изменениям в результате манипуляций. Исследователи создали обширный обучающий набор изображений, написав скрипт Photoshop, использующий фильтр Face Aware Liquify на тысячах случайных фотографий из Интернета.

Интересно, что созданный в Adobe метод оказался куда более совершенным, чем человеческий глаз. Если люди в среднем определяли манипуляции с лицами с помощью популярного метода Face Aware Liquify лишь в 53 % случаев (то есть чуть больше, чем случайный выбор), то алгоритм на основе ИИ — в 99 %. Это весьма достойный результат.

Adobe обещает продолжить работу в направлении создания методов определения манипуляций с изображениями, видео, звуком и документами. Цель состоит в том, чтобы не только определить манипуляции, но также указать на их характер и, по возможности, отменить изменения, внесённые в оригинал.

Исследователь Adobe Ричард Чжан прокомментировал предварительные результаты так: «Идея создания волшебной универсальной кнопки, позволяющей вернуть отредактированному изображению первозданный вид, всё ещё далека от реальности. Но мы живём в мире, где всё труднее доверять цифровой информации, которую мы потребляем, и я с нетерпением жду дальнейшего прогресса в этой области исследований».